Индексация сайта поисковыми роботами — процесс сканирования и обработки данных этого сайта и добавления его в специальную базу для последующего ранжирования в выдаче. Именно благодаря индексации сайты попадают в поле видимости потенциальных клиентов. Однако иногда сайты или их отдельные страницы нужно закрывать от индексации. В этой статье рассмотрим, в каких случаях требуется это сделать, разберем способы скрытия ресурсов от поисковых краулеров и покажем, как узнать, закрыт ли сайт от индексации или нет.

Что нужно закрывать от индексации

Важно, чтобы в поисковой выдаче были исключительно целевые страницы, соответствующие запросам пользователей. Поэтому от индексации в обязательном порядке нужно закрывать:

1. Бесполезные для посетителей страницы или контент, который не нужно индексировать. В зависимости от CMS, это могут быть:

- страницы административной части сайта;

- страницы с личной информацией пользователей, например, аккаунты в блогах и на форумах;

- дубли страниц;

- формы регистрации, заказа, страница корзины;

- страницы с неактуальной информацией;

- версии страниц для печати;

- RSS-лента;

- медиа-контент;

- страницы поиска и т.д.

Способы закрытия сайта от индексации

Закрыть сайт или страницы сайта от поисковых краулеров можно следующими способами:

- С помощью файла robots.txt и специальных директив.

- Добавив метатеги в HTML-код отдельной страницы.

- С помощью специального кода, который нужно добавить в файл .htaccess.

- Воспользовавшись специальными плагинами (если сайт сделан на популярной CMS).

С помощью robots.txt

Robots.txt — текстовый файл, который поисковые краулеры посещают в первую очередь. Здесь для них прописываются указания — так называемые директивы.

Этот файл должен соответствовать следующим требованиям:

- название файла прописано в нижнем регистре;

- он имеет формат .txt;

- его размер не превышает 500 КБ;

- находится в корне сайте;

- файл доступен по адресу URL сайта/robots.txt, а при его запросе сервер отправляет в ответ код 200 ОК.

В robots.txt прописываются такие директивы:

- User-agent. Показывает, для каких именно роботов предназначены директивы.

- Disallow. Указывает роботу на то, что некоторое действие (например, индексация) запрещено.

- Allow. Напротив, разрешает совершать действие.

- Sitemap. Указывает на прямой URL-адрес карты сайта.

- Clean-param. Помогает роботу Яндекса правильно определять страницу для индексации.

Имейте в виду: поскольку информация в файле robots.txt — это скорее указания или рекомендации, нежели строгие правила, некоторые системы могут их игнорировать. В таком случае в индекс попадут все страницы вашего сайта.

Полный запрет сайта на индексацию в robots.txt

Вы можете запретить индексировать сайт как всем роботам поисковой системы, так и отдельно взятым. Например, чтобы закрыть весь сайт от робота Яндекса, который сканирует изображения, нужно прописать в файле следующее:

User-agent: YandexImages Disallow: /

Чтобы закрыть для всех роботов:

User-agent: * Disallow: /

Чтобы закрыть для всех, кроме указанного:

User-agent: * Disallow: / User-agent: Yandex Allow: /

В данном случае, как видите, индексация доступна для роботов Яндекса.

Запрет на индексацию отдельных страниц и разделов сайта

Для запрета на индексацию одной страницы достаточно прописать ее URL-адрес (домен не указывается) в директиве файла:

User-agent: * Disallow: /registration.html

Чтобы закрыть раздел или категорию:

User-agent: * Disallow: /category/

Чтобы закрыть все, кроме указанной категории:

User-agent: * Disallow: / Allow: /category

Чтобы закрыть все категории, кроме указанной подкатегории:

User-agent: * Disallow: /uslugi Allow: /uslugi/main

В качестве подкатегории здесь выступает «main».

Запрет на индексацию прочих данных

Чтобы скрыть директории, в файле нужно указать:

User-agent: * Disallow: /portfolio/

Чтобы скрыть всю директорию, за исключением указанного файла:

User-agent: * Disallow: /portfolio/ Allow: avatar.png

Чтобы скрыть UTM-метки:

User-agent: * Disallow: *utm=

Чтобы скрыть скриптовые файлы, нужно указать следующее:

User-agent: * Disallow: /scripts/*.ajax

По такому же принципу скрываются файлы определенного формата:

User-agent: * Disallow: /*.png

Вместо .png подставьте любой другой формат.

Через HTML-код

Запретить индексировать страницу можно также с помощью метатегов в блоке <head> в HTML-коде.

Атрибут «content» здесь может содержать следующие значения:

- index. Разрешено индексировать все содержимое страницы;

- noindex. Весь контент страницы закрыт от индексации;

- follow. Разрешено индексировать ссылки;

- nofollow. Разрешено сканировать контент, но ссылки при этом закрыты от индексации;

- all. Все содержимое страницы подлежит индексации.

Открывать и закрывать страницу и ее контент можно для краулеров определенной ПС. Для этого в атрибуте «name» нужно указать название робота:

- yandex — обозначает роботов Яндекса:

- googlebot — аналогично для Google.

<html>

<head>

<meta name="robots" content="noindex, nofollow" />

</head>

<body>...</body>

</html>

Чтобы запретить индексировать страницу краулерам Google, нужно ввести:

<meta name="googlebot" content="noindex, nofollow"/>

Чтобы сделать то же самое в Яндексе:

<meta name="yandex" content="none"/>

На уровне сервера

В некоторых случаях поисковики игнорируют запреты и продолжают индексировать все данные. Чтобы этого не происходило, рекомендуем попробовать ограничить возможность посещения страницы для отдельных краулеров на уровне сервера. Для этого в файл .htaccess в корневой папке сайта нужно добавить специальный код. Для краулеров Google он будет таким:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

Для краулеров Яндекса таким:

SetEnvIfNoCase User-Agent "^Yandex" search_bot

На WordPress

В процессе создания сайта на готовой CMS нужно закрывать его от индексации. Здесь мы разберем, как сделать это в популярной CMS WordPress.

Закрываем весь сайт

Закрыть весь сайт от краулеров можно в панели администратора: «Настройки» => «Чтение». Выберите пункт «Попросить поисковые системы не индексировать сайт». Далее система сама отредактирует файл robots.txt нужным образом.

Закрытие сайта от индексации через панель администратора в WordPress

Закрываем отдельные страницы с помощью плагина Yoast SEO

Чтобы закрыть от индексации как весь сайт, так и его отдельные страницы или файлы, установите плагин Yoast SEO.

Для запрета на индексацию вам нужно:

- Открыть страницу для редактирования и пролистать ее вниз до окна плагина.

- Настроить режим индексации на вкладке «Дополнительно».

Закрытие от индексации с помощью плагина Yoast SEO

Настройка режима индексации

Запретить индексацию сайта на WordPress можно также через файл robots.txt. Отметим, что в этом случае требуется особый подход к редактированию данного файла, так как необходимо закрыть различные служебные элементы: страницы рассылок, панели администратора, шаблоны и т.д. Если этого не сделать, в поисковой выдаче могут появиться нежелательные материалы, что негативно скажется на ранжировании всего сайта.

Как узнать, закрыт ли сайт от индексации

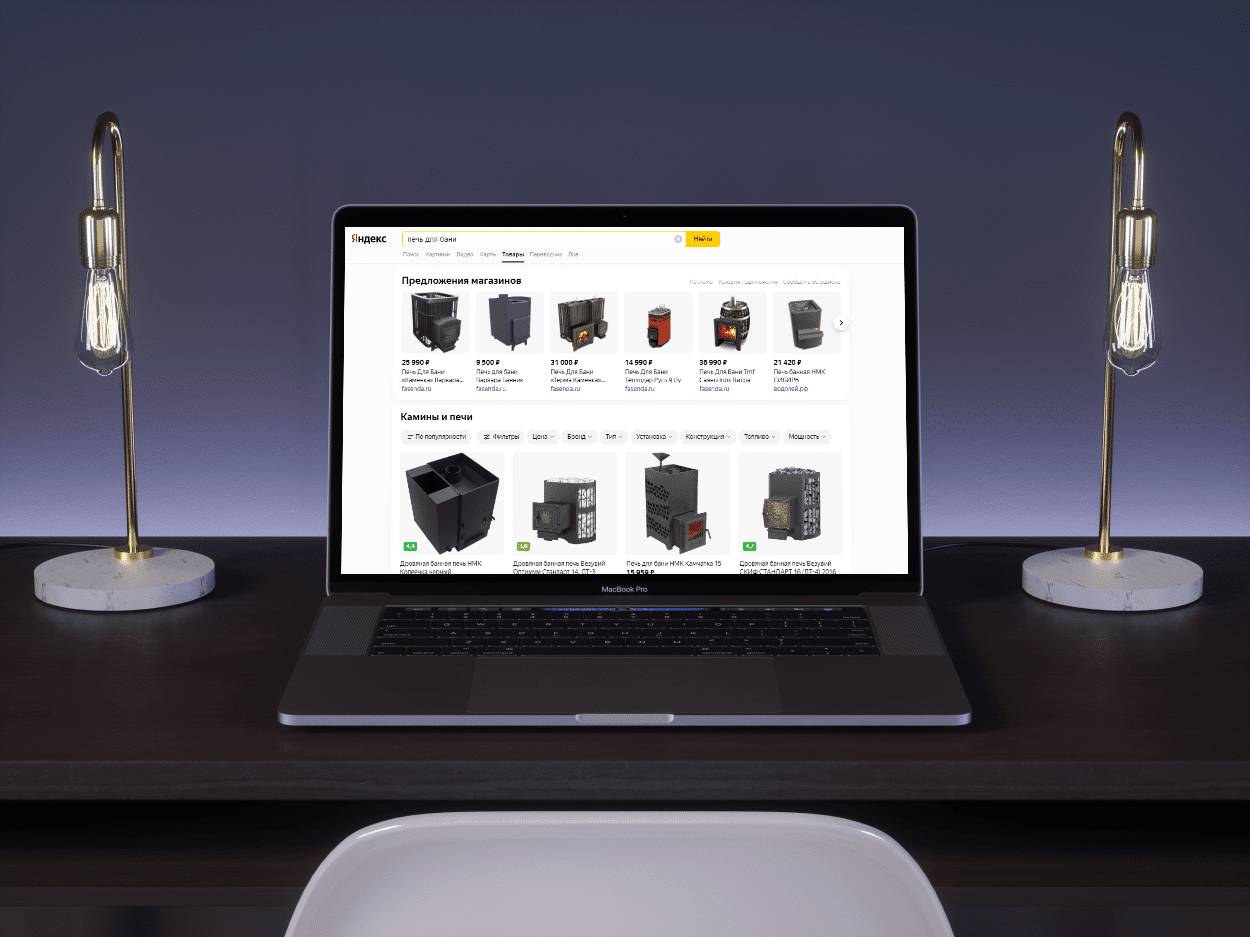

В Яндекс.Вебмастере

Для проверки вам нужно пройти верификацию в Яндексе, зайти в Вебмастер, в правом верхнем углу найти кнопку «Инструменты», нажать и выбрать «Проверка ответа сервера».

Проверка возможности индексации страницы в Яндекс.Вебмастере

В специальное поле на открывшейся странице вставляем URL интересующей страницы. Если страница закрыта от индексации, то появится соответствующее уведомление.

Так выглядит уведомление о запрете на индексацию страницы

Таким образом можно проверить корректность работы файла robots.txt или плагина для CMS.

В Google Search Console

Проверка возможности индексации в Google Search Console

С помощью поискового оператора

Введите в поисковую строку следующее: site:https:// + URL интересующего сайта/страницы. В результатах вы увидите количество проиндексированных страниц и так поймете, индексируется ли сайт поисковой системой или нет.

Проверка индексации сайта в Яндексе с помощью специального оператора

Проверка индексации отдельной страницы

С помощью такого же оператора проверить индексацию можно и в Google.

С помощью плагинов для браузера

Мы рекомендуем использовать RDS Bar. Он позволяет увидеть множество SEO-показателей сайта, в том числе статус индексации страницы в основных поисковых системах.

Плагин RDS Bar

Итак, теперь вы знаете, когда сайт или его отдельные страницы/элементы нужно закрывать от индексации, как именно это можно сделать и как проводить проверку, и можете смело применять новые знания на практике.