Страницы сайта попадают в органическую выдачу после индексации их поисковым роботом. Для процесса индексации каждого отдельно взятого сайта, со стороны поисковика выделяется определенный лимит – краулинговый бюджет (количество страниц, подлежащих индексации в рамках одного визита краулера). Первоначально эта технология была внедрена Google, а позже появилась у остальных поисковиков. Ниже разберем подробнее, что такое краулинговый бюджет, способы и причины его оптимизации.

Что такое краулинговый бюджет?

Краулинг представляет собой процесс обход поисковым роботом (краулером, пауком) документов сайта для последующего их добавления в индекс. Любая поисковая система старается оптимизировать процесс индексации сайтов, выделяя на каждый из них лимиты. Краулинговый бюджет сайта определяет количество документов, которое поисковый робот должен обойти за одно посещение или другой временной промежуток. Например, если бот обходит 60 URL-адресов в сутки, то на ваш сайт выделяется 1800 страниц краулингового бюджета ежемесячно.

Перечислим факторы, которые имеют существенное влияние на объем краулингового бюджета:

- Скорость загрузки страниц. Слишком медленная может «вынудить» краулера сократить лимиты и часть страниц окажется не проиндексированной.

- Частые падения сервера, когда сайт оказывается недоступен. Если это произошло в тот момент, когда сайт индексировал бот, то, соответственно, часть страниц останется за его полем видимости.

- Скорость добавления новых материалов или обновления старых. Если на сайте нет движения, то поисковая система снижает лимиты.

- Наличие дублей страниц, либо страниц, содержащих контент, не отвечающий запросам пользователей. Это может произойти при использовании не оптимизированной под SEO CMS системы и неправильной настройки robots.txt, когда краулеру становятся доступны, например, служебные страницы. В таком случае, качество индексации падает в целом, но может и урезаться краулинговый бюджет.

Почему краулинговый бюджет важен для SEO?

На относительно маленьком проекте о краулинговом бюджете можно не задумываться, т.к. его количества хватает с избытком на то, чтобы проиндексировать новые страницы. Т.е. количество публикаций новых материалов ниже, чем выделенная квота со стороны поисковика.

Однако ситуация кардинально меняется, если на ресурсе публикуется большое количество новых страниц и бюджета не хватает на то, чтобы краулер их обошел. В итоге скорость попадания документов в индекс замедляется, а сайт теряет потенциальных посетителей. Именно поэтому, если владельцы ресурса занимаются SEO продвижением и хотят видеть сайт в ТОПе, то они должны озаботиться оптимизацией краулингового бюджета.

Также проблема актуальна, если старые страницы периодически редактируются, но поисковики с ощутимой задержкой обновляют информацию в индексе. Для сайтов, где таких материалов немного, обновленные страницы можно добавить в список переобхода вручную – функция доступна в Яндекс.Вебмастере и Google Search Console. Однако сделать это для многотысячного количества страниц проблематично.

Как следить за краулинговым бюджетом?

Проследить за тем, какие страницы посещались краулерами, можно с помощью логов сервера. По умолчанию на большинстве хостингов эта опция включена. Логи записываются в специальный файл – access.log, который можно найти в папке logs по протоколу FTP.

Путь к папке logs

Внутри файла, который открывается любым текстовым редактором, находятся строки, которые показывают:

- IP-адрес, с которого происходило посещение.

- Адрес страницы.

- GET-запрос, означает получение данных. Существует еще команда POST – отправка данных.

- page/2 – обращение было сделано ко 2 странице.

- Код ответа, в штатном состоянии, страницы должны отдавать код 200.

- Количество переданных байтов информации.

- Общие данные о пользователях (операционная система, устройство и т.д.). Также по этой графе определяются поисковые краулеры.

Документ logs

Работать из текстового редактора, когда на сайте большое количество уникальных посещений, крайне неудобно и трудозатратно. Поэтому в качестве рабочей среды используются специальные программы:

- SEO Log File Analyser.

- AWStats.

В качестве примера приведем интерфейс SEO Log File Analyser. Порядок работы с ней:

- Скачиваем лог файл.

- Открыв программу, сразу будет предложено загрузить этот файл и указать URL-адрес изучаемого сайта.

- После выведены данные из файла в удобной структурированной форме с графиками.

Просмотр логов в SEO Log File Analyser

- На вкладке «User Agents» показываются боты поисковиков и подробная информация по ним.

- Каждая из вкладок предоставляет исчерпывающие данные по страницам, ботам, кодам ответов и прочим.

SEO Log File Analyser позволяет увидеть какие страницы посетил тот или иной краулер, в какое время и сколько раз. Сводные данные дают понять, на каких страницах имеются проблемы, распределение ответов сервера, какие документы обходятся ботами, не смотря на запреты от индексации и т.д.

Оптимизация краулингового бюджета

Оптимизация краулингового бюджета может затянуться на продолжительное время. Цель – привлечь ботов на важные разделы и страницы и исключить их посещения от мусорных. Перечислим способы управления краулинговым бюджетом.

Работа с кодами ответов страниц

Страница при нормальной ее работе отдает 200 (OK) код, либо 301 при редиректе. Если говорить про редиректы, то при получении 302 кода, краулер «подумает», что посетил недоступную страницу – бюджет будет потрачен впустую.

Немного сложнее обстоят дела с 404 кодом – страница не найдена. Если возвращается 404, то это сигнал боту о том, что возможно страница появится позже, поэтому он периодически будет ее посещать. Если на сайте присутствует много удаленных страниц, но возвращающих 404 код, то лимиты будут тратиться в больших количествах.

Особое отношение со стороны краулеров к 500-м кодам ответа, которые означают, что ресурс временно недоступен. Это явный признак некачественного сайта, на который поисковая система вряд ли захочет тратить свои ресурсы, и постепенно начнет снижать краулинговый бюджет в целом.

Редиректы

Для поискового робота сайт может находиться сразу на нескольких адресах. К примеру, с WWW, без WWW, по HTTP и HTTPS. Если перенаправление не настроено, то главное зеркало определяется поисковиками автоматически. В таком случае, управление краулинговым бюджетом может усложниться.

Иногда оптимизаторами допускаются ошибки в редиректах, например, перенаправление происходит два и более раз. Соответственно, лимиты тратятся при каждом редиректе.

Карта сайта

Карта сайта – XML-файл, который поисковый бот посещает в первую очередь. Из нее он узнает о страницах, которые нужно индексировать. Данный файл носит для бота рекомендательный характер, не факт, что информация из него будет учитываться, но рекомендуется его создать и пополнять по мере публикации материалов на сайте, либо создать динамическую карту сайта.

Грамотная структура сайта

Краулер может индексировать только те документы, на которые ведут ссылки из других проиндексированных страниц, либо указанных в файле sitemap.xml. Соответственно, если структура сайта организованна таким образом, что некоторые документы не имеют прямых ссылок, то и индексации придется ждать долго.

Если говорить про краулинговый бюджет, то документы сайта, имеющие малое количество входящих внутренних ссылок, реже посещаются ботами. Поэтому важные разделы и страницы должны иметь как минимум 8 и более входящих ссылок.

По структуре сайт должен быть как можно проще. Следует избегать большого уровня вложенности страниц, стараться не превышать его более 4-х. Это значит, что пользователь с главной страницы должен добраться до любой другой не более чем за 4 клика.

Дубликаты страниц

Такое явление встречается в некоторых CMS системах, когда одна и та же страница доступна по разным URL-адресам. В последующем произойдет их склейка, и поисковик сам определит какая из страниц будет в выдаче, но в момент индексации на каждую из них тратятся лимиты. Если таких страниц не много, то это не критично. Но в случае крупных проектов, может заметно сказаться на скорости индексации сайта в целом.

Чтобы избежать этой проблемы, настройте CMS, установив готовые плагины, которые принудительно удаляют дубли. Обязательно проработайте файл robots.txt, закрыв в нем от индексации все дежурные страницы (например, директории админки, страницы входа, формы, корзины и т.д.).

Часто на больших сайтах-каталогах, контент на страницах схож. В этом случае, для увеличения краулингового бюджета, рекомендуется уникализировать тексты.

Закрытие внутренних ссылок от индексации

Если с текущей страницы нет необходимости направлять бота на другие документы, на которые указаны URL-адреса, то ссылки можно закрыть атрибутом rel=«nofollow». Но опять же, данная команда может не учитываться краулером.

Заголовок Last-Modified

Цель заголовка Last-Modified – сообщение поисковому боту (или браузеру) информацию, связанную с последними изменениями текущей страницы. При правильной настройки заголовка:

- Ускоряется загрузка страницы.

- Снижается нагрузка на сервер.

- В сниппете органической выдаче может показываться дата последнего изменения страницы.

- Если пользователь сортирует страницы в поисковой выдаче по дате, то наиболее свежие, занимают топовые позиции.

- Значительно ускоряется скорость индексации страницы.

Оптимизация краулингового бюджета в этом случае происходит за счет того, что бот изначально понимает, какие страницы добавлялись или редактировались. И вместо того, чтобы обходить весь сайт, индексация происходит точечно.

Наращивание ссылочного профиля

Ссылочный профиль влияет не только на ранжирование страниц, но и на оптимизацию краулингового бюджета. Документы, которые имеют большое количество внешних ссылок (с других ресурсов), могут чаще посещаться краулерами. Поэтому, путем грамотного распределения внешней ссылочной массы, можно управлять поведением поисковых ботов.

Циклические ссылки

Такое явление может произойти, если страница ссылается сама на себя. Оно несет в себе несколько проблем: вводит в заблуждение пользователей, тратит ссылочный вес и расходует краулинговый бюджет. Чаще всего, циклические ссылки встречаются в хлебных крошках, когда их хвост заканчивается активной ссылкой на текущую страницу.

Топ вопросов и ответов по краулинговому бюджету

Мы собрали наиболее часто встречающиеся вопросы, касательно краулингового бюджета сайта.

По каким принципам индексируются большие сайты?

Имея определенный лимит на сканирование страниц, бот постепенно продвигается по всем ссылкам сайта. Важно, чтобы структура была логичной и все необходимые документы имели входящие ссылки.

По какому принципу рассчитывается краулинговый бюджет?

Как уже понятно из статьи, каждый сайт имеет свой уникальный лимит краулингового бюджета. На его формирование влияют два основных момента:

- Общая ценность и авторитет сайта. Определяется она по множеству факторов, например, по качеству и количеству ссылочной массы с других ресурсов, актуальности информации и т.д.

- Скорость работы сервера. Даже при больших нагрузках, сервер должен поддерживать корректную работу сайта. Если в этом есть проблемы, то краулинговый бюджет будет снижен.

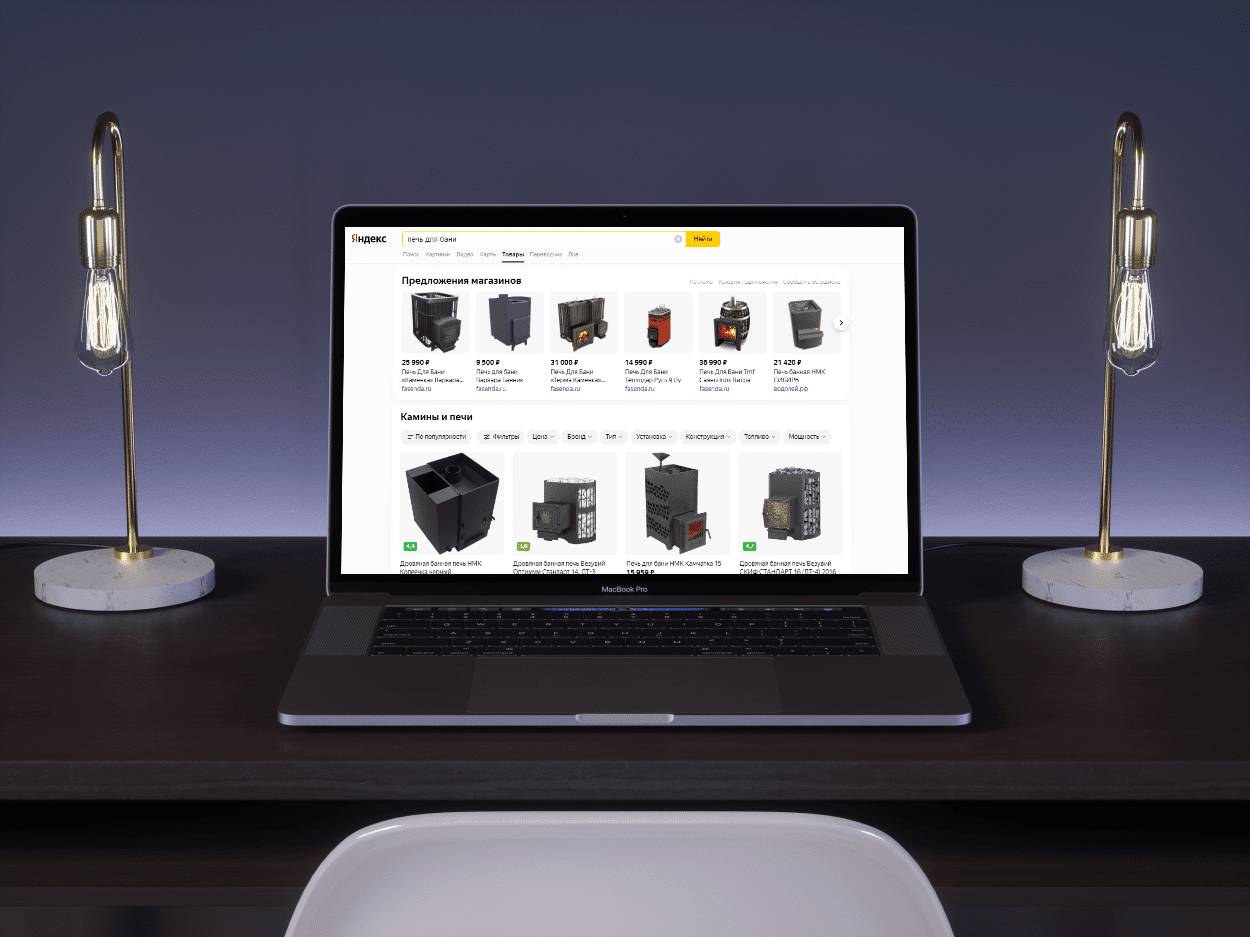

Как оптимизировать краулинговый бюджет для интернет-магазина?

Такие сайты, как правило, имеют большое количество страниц и сложную структуру. В первую очередь, желательно сделать страницы уникальными, ну или хотя бы большую часть из них. Все вышеперечисленные рекомендации актуальны и для интернет-магазинов, но кроме этого, при наличии большого количества вариаций фильтров, может потребоваться их проработка.

Речь идет о том, что каждый фильтр – отдельная посадочная страница, которую можно успешно продвигать в поисковой выдаче. Но не все варианты фильтров могут иметь хорошую частотность, но при индексации тратят краулинговый бюджет.

Имеет ли новый сайт краулинговый бюджет?

Молодые сайты получают минимальное количество лимитов, достаточное для того, чтобы поисковик смог оценить первоначальное качество ресурса, скорость публикации новых материалов и т.д.

По мере роста сайта, увеличивается и бюджет. Чем более востребованным становится сайт, тем чаще его посещают поисковые боты.

Что, если не оптимизировать его?

В первую очередь, это приведет к задержкам в индексации страниц. Свежий материал будет значительно дольше добираться до поисковой выдачи. Вторым моментом (косвенным) выступает плохая оптимизация сайта в целом. Например, в индекс будут попадать мусорные страницы, что в итоге приведет к плохому ранжированию полезных.

Можно ли ограничить скорость обхода?

Да, в панелях вебмастеров есть специальные настройки, в которых можно задавать ограничения на скорость индексирования.

Настройка скорости обхода вручную

Частота сканирования

Обязательно прорабатывайте все недочеты сайта для максимальной оптимизации краулингового бюджета. Это значительно поможет улучшить ранжирование страниц сайта в органической выдаче и повысить его качество в целом.